Deep Fakes – die Gefahr hinter manipulierten Videos

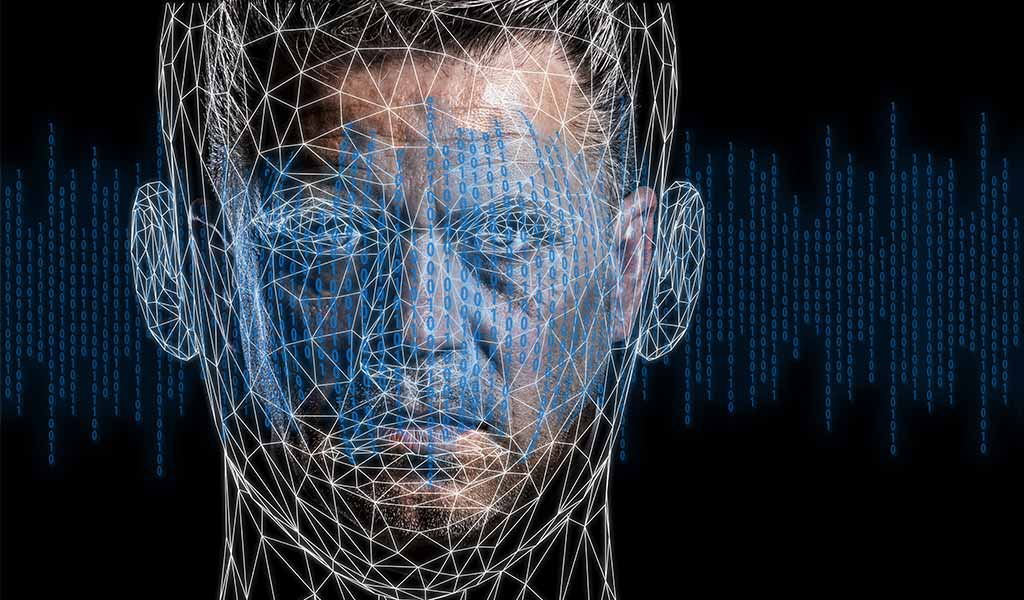

Luisa Paulin DreckmannGeschätzte Lesedauer: 2 MinutenDeep Fakes sind Fotos, Videos oder Audio-Dateien, die mithilfe von Techniken der Künstlichen Intelligenz verändert und verzerrt werden. Der Begriff setzt sich aus Deep Learning (tiefes Lernen) und Fake (Fälschung) zusammen. Wie funktioniert Deep Fake?

Deep Fake – Täuschend echte Videos

Künstliche Intelligenz verändert unseren Alltag immens – und kann zudem extrem hilfreich sein. Doch was, wenn intelligente Technologien für Falschinformationen ausgenutzt werden? Ein neues Phänomen ist der sogenannte Deep Fake: Hier wird Videomaterial gezielt manipuliert, indem z. B. Personen des öffentlichen Lebens mit Hilfe modernster Software Sätze in den Mund gelegt werden, die sie nie gesagt haben. Doch was hat es damit genau auf sich?

Was genau macht Deep Fakes aus?

Deep Fakes sind manipulierte Medieninhalte, die mit Hilfe von Künstlicher Intelligenz produziert werden. Von der klassischen Medienmanipulation grenzen sich Deep Fakes durch die Verwendung intelligenter Technologien ab.

Neu ist zum Beispiel die Face2Face Software: Sie wurde von einem achtköpfigen Forscherteam aus Deutschland, Frankreich und den USA entwickelt. Die Software ermöglicht es unter anderem, die Gesichter von Prominenten durch einen Algorithmus im Video Dinge sagen zu lassen, die man sie sagen lassen will. Dabei werden menschliche Alleinstellungsmerkmale wie Mimik, Gestik und Stimmlage täuschend echt imitiert.

Fake Klitschko telefoniert mit Franziska Giffey

Opfer eines gefälschten Videoanrufs wurde kürzlich die Regierende Bürgermeisterin von Berlin, Franziska Giffey. Sie nahm im Roten Rathaus an einem digitalen Gespräch mit Vitali Klitschko teil. Zunächst schien alles unauffällig – der Bürgermeister von Kiew wirkte in Hinblick auf Mimik und Stimme authentisch. Erst nach einer halben Stunde fiel durch merkwürdige Fragen auf, dass bei dem Gespräch etwas nicht stimmen kann. Das Videotelefonat wurde frühzeitig abgebrochen. Zunächst ging man davon aus, dass es sich hier um einen Deep Fake handelte. Neuste Erkenntnisse sprechen zwar dagegen. Der Anruf war allerdings trotzdem sehr aufwendig gefälscht. Deep Fakes hätten wohl einen ebenso täuschend echten Eindruck hinterlassen können.

Die Gefahr der gefälschten Videos

Zu Comedyzwecken mögen Deep Fakes amüsant sein – diese Form der KI birgt aber auch ein erhebliches Risiko. Durch die realistische Wirkung des Videomaterials gestaltet es sich deutlich leichter, Falschinformationen in der Öffentlichkeit zu verbreiten. Zukünftig könnte manipuliertes Medienmaterial nicht nur für Irritationen sorgen, sondern insbesondere im politischen Kontext immer gefährlicher werden.

Mit Hinblick auf den technologischen Fortschritt werden wir uns in Zukunft wohl öfter die Frage stellen müssen:

- Welche Videoinhalte sind echt?

- Welche sind manipuliert?

- Und wie erkennt man gefälschte Medieninhalte?

Diese Konsequenz zieht nun auch Franziska Giffey aus dem gefakten Videotelefonat mit dem vermeintlichen Vitali Klitschko: Sie und ihr Team wollen zukünftig misstrauischer gegenüber Anfragen zu Videoanrufen werden.